Во время золотой лихорадки поколения искусственного интеллекта OpenAI нанесла решающий удар по существующим инструментам генерации видео, таким как Imagen от Google, Runway Gen-2 или Make-A-Video от Meta.

Эти конкурирующие проекты были размытыми, с низким разрешением, пластиковыми по внешнему виду и в целом рудиментарными – скорее беглый взгляд в будущее синтетических изображений, чем жизнеспособные продукты. Sora от OpenAI – совершенно другой зверь, использующий текстовые подсказки для создания фотореалистичных людей, животных и пейзажей. В нем используются методы обработки, имитирующие зернистость пленки или отснятый материал с мобильного телефона, а также используются профессиональные методы отслеживания, перемещения тележки и стрелы.

Она не идеальна, но чертовски близка к тому, чтобы быть неотличимой от реальности.

Это не идеально, но это чертовски близко к тому, чтобы быть неотличимым от реальности.

Результаты удивительные. Серьги женщины естественно покачиваются в такт ее походке, свет реалистично отражается от ее очков и залитых дождем токийских улиц. В другом видео несколько гигантских мохнатых мамонтов приближаются, ступая по заснеженному лугу, их тени обволакивают их самих и окружающую среду, как и ожидалось. В нескольких видеороликах нет никаких признаков сверхъестественной долины, которая заставляла синтетические видеоролики прошлого кричать о том, что что-то было искусственным.

Эти впечатляющие результаты также вызывают тревогу.

Помимо опасений по поводу того, что это значит для творческих профессий (как показали забастовки голливудских писателей и актеров 2023 года) или того, что это значит для нашего понимания фотографий и видео, самым большим тревожным звоночком является то, что это означает для будущего объективной правды, дезинформации и власти.

Если вы не можете сказать, что реально (видео, созданные искусственным интеллектом, которые выглядят реальными, а также реальные видео, которые другие называют подделкой), ничто не реально, кроме того, во что вы предпочитаете верить. Последнее десятилетие показало нам во всем мире опасность феномена «эхо-камер», подпитываемых социальными сетями; с избирательными фактами приходит избирательная реальность и, в конечном счете, дальнейшее разделение и нанесение вреда обществу.

Что реально?

Глядя на приведенный выше пример с мохнатыми мамонтами, легко решить, что это фейк. Как зритель, вы, возможно, помните, что мамонты вымерли около 4000 лет назад, поэтому считаете, что это должна быть какая-то иллюстрация, созданная искусственным интеллектом.

(По крайней мере, до тех пор, пока мы не начнем клонировать мохнатых мамонтов.)

Но задумайтесь на мгновение, что произойдет, если такое видео представить для людей, не подозревающих, что мамонты вымерли. Это не так надуманно, как вам может показаться. Как сообщала BBC в прошлом году, созданные с помощью искусственного интеллекта научные видеоролики на YouTube, предназначенные для детей, оказались необычайно эффективны для убеждения воспитанников детских садов в том, что египетские пирамиды были электрическими генераторами, инопланетяне были реальными и что НАСА скрывало, что деятельность человека не сыграла никакой роли в изменении климата. Все это ложь, но это не помешало 5-летним детям поверить в неё и просматривать видео в качестве доказательства этих утверждений.

Такой инструмент, как Sora, который обещает легко и быстро предоставить фотореалистичных людей и реальное окружение любому, практически без обучения, действительно представляет собой проблему со стороны злоумышленников, стремящихся обмануть детей (и взрослых), и это должно заставить задуматься.

Для реалистичного выполнения подделок в прошлом требовался определенный уровень навыков и вычислительных мощностей, но с такими инструментами, как Sora, порог был снижен для всех, у кого есть клавиатура, немного времени и намерений.

OpenAI не раскрывает, сколько времени потребовалось на создание каждого образца созданного видео. Я видел несколько заявлений о том, что их можно сделать за считанные минуты, но, основываясь на моем опыте создания статических изображений с помощью искусственного интеллекта, я подозреваю, что для получения идеальных результатов потребуются часы или дни тонкой настройки и редактирования. В публикациях на X, последовавших за анонсом Соры, генеральный директор OpenAI Сэм Альтман попросил подсказки у читателя и представил два генерированных видео (готовящая бабушка и фантазию о морских существах на велопараде) примерно за 90 минут.

OpenAI также не поделилась, какие источники видео и изображений использовались для обучения Sora или, что более важно, использовались ли работы, защищенные авторским правом. На компанию, которая также производит чат-бота ChatGPT и генератор изображений DALL-E, подали в суд по обвинению в использовании работ, защищенных авторским правом, для подготовки этих предыдущих продуктов.

Несмотря ни на что, надпись на стене. Скоро каждый Том, Дик и Харриет смогут снимать убедительные фальшивые видео. OpenAI, похоже, на каком-то уровне осознала опасность инструментов искусственного интеллекта.

Большая часть анонса была посвящена разделу безопасности с заметным заголовком меню, в котором признавались риски дезинформации и нанесения вреда обществу. У платформы пока нет даты публичного релиза; в настоящее время она доступна только избранной группе тестировщиков, которым также поручено помогать выявлять и оценивать риски и потенциальный вред. Я надеюсь, что этот уровень заботы искренен, а не на словах.

Дикий дикий запад

В настоящее время нет никаких правил в отношении инструментов, генерирующих искусственный интеллект. Закон ЕС об искусственном интеллекте может стать первым, если будет принят, и будет регулировать отрасль, ограничивая использование искусственного интеллекта корпорациями и правоохранительными органами, а также предоставляя общественности возможность подавать жалобы. В США и Китае также предпринимается несколько попыток регулировать использование искусственного интеллекта, но в настоящее время они в лучшем случае носят лоскутный характер.

Единственные меры предосторожности, действующие на момент написания этой статьи, были приняты самими компаниями, работающими над искусственным интеллектом.

OpenAI использует языковые фильтры для проверки и отклонения текстовых подсказок, содержащих элементы, которые, по его мнению, содержат насилие, сексуальность, ненависть, или попытки использовать материалы, защищенные авторским правом, или изображения знаменитостей. Планируется внедрить метаданные C2PA в любую общедоступную версию инструмента.

C2PA (Коалиция за происхождение и аутентичность контента) – это проект по разработке стандартов аутентификации, поддерживаемый Adobe, Sony, BBC и другими. Он объединяет усилия CAI (Content Authenticity Initiative) и Project Origin по решению проблемы происхождения и аутентичности изображений путем установления стандартов авторства и метаданных наряду с инструментами с открытым исходным кодом для информирования общественности о подлинности контента.

Присоединяясь к этой группе и принимая стандарт, OpenAI, похоже, признает необходимость бумажного следа для определения того, что является подлинным, а что синтетическим. Пока Sora не станет достоянием общественности, мы не будем знать, как это будет реализовано, как общественность будет обучена использованию инструментов аутентификации или, что более важно, ценности использования таких инструментов.

Однако в этом признании отсутствует одна ключевая вещь. Усилия C2PA в основном нацелены на журналистов, которые, возможно, больше всего обеспокоены аутентификацией СМИ. Что значат происхождение и подлинность изображений для обычного пользователя Sora?

Показательный пример: rage bait. Критическим показателем успеха в социальных сетях является вовлеченность – сколько людей взаимодействуют с вашим контентом: рубрика лайков, комментариев, потраченного времени, публикации, сохранения и подписки. В этой модели важны только эти показатели, определяющие вовлеченность, поэтому не имеет значения, соответствует ли что-либо действительности. Цель оправдывает средства.

Новые технологии – это круто, и осознание риска велико, но взять на себя ответственность за джинна в бутылке, прежде чем выпустить его наружу, – правильный поступок. Мы были вовлечены в многолетние дебаты об изображениях искусственного интеллекта и о том, являются ли они фотографиями, произведениями искусства, защищенными авторским правом или полезными. Мы посмеивались над тем, что искусственный интеллект не может придать рукам человеческий вид или тексту разборчивый вид. Но если Sora и напоминает нам о чем-то, так это о том, что технологии развиваются быстрее, чем мы, люди, и у нас есть ограниченное время, чтобы действовать на опережение, прежде чем мы начнем реагировать на любой вред.

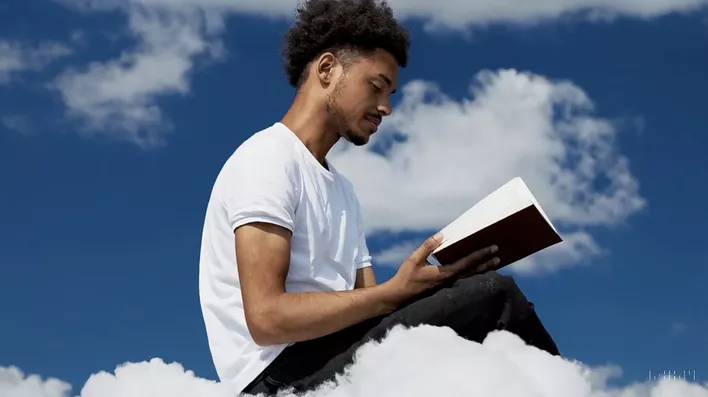

На данный момент это худшее видео, созданное искусственным интеллектом, которое когда-либо смотрелось. Год назад мы хихикали над тем, как инструменты искусственного интеллекта боролись с человеческими телами и не могли реалистично изобразить Уилла Смита, поедающего спагетти, а 11 месяцев спустя у нас появилось видео, подобное приведенному ниже, на котором мужчина читает книгу.

В своей презентации OpenAI поделилась примерами инструмента, который все еще борется с руками, физикой и перекрывающимися животными. Если присмотреться к деталям, можно сказать, что что-то ненастоящее, но для этого требуется нечто большее, чем беглый взгляд. Или, в случае социальных сетей и повторного обмена скриншотами, когда визуальное сжатие снижает качество изображения, это требует от нас скептицизма и поиска источника, чтобы убедиться самим. Инструменты C2PA могут помочь, если их правильно реализовать с технической стороны, но для них также потребуются серьезные усилия по обучению медиаграмотности.

Глядя на то, как далеко продвинулось видео, созданное с помощью искусственного интеллекта за 11 месяцев, кажется неизбежным, что странности изображений и видео, созданных с помощью искусственного интеллекта, со временем разрешатся сами собой. На данный момент это всё ещё худшее видео, созданное искусственным интеллектом, которое когда-либо показывались. Имейте это в виду.

Дезинформация, превращенная в оружие

Возможно, это потому, что я работаю в газетах, журналах и тележурналистике, но мир, в котором правда может быть с такой легкостью похоронена под вымыслом, кажется мне опасно близким к антиутопии.

Я вспоминаю истории моей семьи из колониального периода Индии и беспорядки вокруг раздела страны в 1947 году. На протяжении поколений колониальные лидеры натравливали друг на друга различные религиозные и региональные группы, чтобы изолировать власть наверху. Дезинформация была ключевой тактикой для поддержки попыток поссорить индуистов и мусульман с целью сохранения контроля.

Для более легкого примера рассмотрим фильм 1975 года «Роллерболл» (да, действительно). В истинной манере 70-х фильм представляет мир будущего, где корпорации и технологии, которые они контролируют, формируют наш мир. В одной из сцен главный герой посещает библиотеку только для того, чтобы узнать, что глобальные корпорации оцифровали и переписали все книги и изменили исторические знания по своему вкусу. Альтернативная история, дополненная «доказательствами», используется для контроля над обществом и поддержания власти.

Самое страшное в обоих примерах то, что они оба основаны на правде: знание – это сила, сила, которая при злонамеренном использовании может быть использована для отвлечения внимания или направления других к желаемому результату.

История изобилует примерами манипулирования изображениями и попытками выдать недостоверные изображения за подлинные; после смерти Авраама Линкольна было подделано знаменитое изображение бывшего президента США. Однако, в отличие от прошлого, распространение более дешевых и простых в использовании инструментов для манипулирования изображениями и фальсификации, таких как искусственный интеллект, позволило любому создавать поддельные изображения, а вскоре и видео, и быстро распространять дезинформацию под видом правды либо для развлечения, либо в более гнусных целях.

Недавно социальные сети были наводнены визуальной дезинформацией о конфликте ХАМАС-Израиль. Изображения из других частей света были дополнены новыми вводящими в заблуждение заголовками, изображения искусственного интеллекта передаются как доказательство военных преступлений, поддельные видеоролики в стиле BBC публикуют вымышленные аккаунты с места событий, а видеоролики мировых лидеров с неточными английскими подписями сеют инакомыслие и путаницу. Проблема на X настолько серьезна, что платформа напомнила пользователям о своей политике дезинформации и о том, как она расширила использование заметок сообщества, своей функции проверки фактов, которую некоторые инсайдеры называют неработающей пластырем.

Сегодняшний поток визуальной дезинформации бросает вызов обществу и тем, кто создает подлинные изображения. Без знания того, что является точным и правдивым, все становится подозрительным, а факты – субъективными. Внезапно плохие актеры могут наводнить социальные сети и мутить воду, затрудняя отделение фактов от вымысла.

Когда я смотрю на Sora и представленные образцы, меня охватывает страх перед медиа-ландшафтом, в котором невозможно с уверенностью сказать, что реально, а что кто-то пытается пустить нам пыль в глаза.

Среди созданных искусственным интеллектом видеороликов, сделанных Sora с анимированными существами и бумажными самолетиками над джунглями, есть несколько интересных видеороликов. Фотореалистичные люди в реальных условиях создают сценарии вооруженной дезинформации. Видео, созданное на основе подсказки «исторические кадры Калифорнии во время золотой лихорадки», – это что угодно, только не историческая документация. Видео от местных жителей со всего мира открывают дверь альтернативным историям этого места.

Среди всех видеороликов, которыми поделился OpenAI, есть одно, которое тревожит меня больше всего. В десятисекундном ролике празднования китайского Нового года по Лунному календарю показана большая толпа, собравшаяся на парад по обе стороны улицы, в то время как две куклы-драконы участвуют в танце драконов в центре.

Видео довольно безобидное; не слишком задумываясь о ракурсе, можно предположить, что это видео со смартфона. Реалистичное освещение, низкое качество изображения, недостаточная глубина резкости, слегка не в фокусе у людей, маскирующих недостаток деталей и размытость в движении, – ничто не дает повода думать, что кто-то стал бы утруждать себя созданием видео с искусственным интеллектом для такой сцены. Наткнувшись на это видео в социальных сетях, вы можете подумать, что оно настоящее, и двигаться дальше, убежденный в этом.

В этом опасность. Это достаточно обыденно, чтобы можно было задаться вопросом: «Зачем кому-то это подделывать?»

Теперь рассмотрим сценарий, в котором плохой актер хотел поместить кого-то в эту сцену и заставить его делать что-то гнусное на заднем плане; возможно, цель должна быть замечена резвящейся с кем-то, с кем она не должна быть. Позже против пострадавшего человека выдвигаются обвинения, и вскоре это фальшивое видео представляется неопровержимым доказательством. Теперь считайте этого человека мишенью в качестве президента страны, и посев семян того, что он ненадежен и вреден для нации, выгоден для противоположной стороны. Этот сценарий не должен казаться слишком надуманным. В прошлом году мы видели, как это происходило с фотоснимками, созданными искусственным интеллектом, во время президентской гонки в США.

Я не буду излагать клише «можно / нужно», но скажу, что должны быть соображения этики, вреда обществу, медиаграмотности и корпоративной ответственности. Теперь, когда джинн вышел на свободу, человечество несет большую ответственность за установку ограждений со средствами коррекции курса в режиме реального времени, а не за то, чтобы разбирать осколки после нанесения ущерба.

Ценностное предложение

Каждый раз, когда я возвращаюсь к технологии создания искусственного интеллекта, у меня возникают те же мысли. Это, несомненно, впечатляет, но какую именно проблему это решает? Если воспользоваться любимой мантрой Кремниевой долины, делает ли это мир лучше?

Я понимаю, что сейчас золотая лихорадка. Я вижу резкий рост цен на акции Nvidia и Microsoft и понимаю, как деньги мотивируют развитие искусственного интеллекта. Я также вижу людей, создающих изобретательные вещи, которые вдохновляют на творчество. Я использовал изображения, созданные искусственным интеллектом, для раскадровок и досок настроения. Но я также вижу опасности.

В примерах видеороликов, которыми поделился OpenAI, ни одно из них не показалось мне убедительным примером использования. По своей сути Sora пытается создать фотореалистичное видео, которое могло бы сойти за настоящее, и я должен задаться вопросом, с какой целью? Поддельные видео могут сойти за настоящие при беглом взгляде. Кто угодно может заявить, что настоящие видео являются подделкой. «Правда» раскалывается, и на ее месте возникают миллионы эхо-камер, которые могут свободно отстаивать свою собственную версию того, что реально для них и их подписчиков.

Я полагаю, что нашим арбитром должен быть взгляд назад. Возможно, однажды искусственный интеллект Криса Нолана объединится с искусственным интеллектом Чарли Кауфмана, чтобы сделать мета-комментарий искусственного интеллекта Оппенгеймера о моменте, когда ИИ-джинн полностью выпущен из бутылки, чтобы, наконец, прояснить, что это значило и чему мы научились.

Оригинал на сайте DPReview

Машинный перевод